خطرناکترین فناوری قرن

به گزارش «تابناک»، روزنامه ایران در ترجمه مقالهای از نیویورکتایمز نوشت: «در حالی که میلیونها کاربر این هفته ویدیوی «تام کروز» بازیگر مشهور را در شبکههای اجتماعی مشاهده میکردند، مشخص شد این تصاویر با فناوری هوش مصنوعی و به روش جعل عمیق ساخته شده است.

ویدیویی که در تیکتاک، توئیتر و سایر شبکههای اجتماعی بین میلیونها کاربر دست به دست شد توسط یک هنرمند جلوههای تصویری و با شبیهسازی یکی از برنامههای «بیل هیدر» بازیگر هالیوودی ساخته شد. در این برنامه که اصل آن متعلق به یک گفتوگوی تلویزیونی در سال ۲۰۰۸ است، «بیل هیدر» در حال تعریفکردن خاطره از اولین ملاقات خود با «تام کروز» در جلسه سناریوخوانی دیده میشود.

گفته میشود در این ویدیو هر زمان «هیدر» مطلبی را از تام کروز نقل میکند، ناگهان اجزای صورت و حالاتش به شکل او درمیآید. یک حساب کاربری در یوتیوب که نخستین بار این تصویر ویدیویی را منتشر کرد پیش از این با استفاده از جعل عمیق، تصویر ویدیویی «آرنولد شوارتزنگر» بازیگر دیگر سینما را پخش کرده بود. فریب میلیونها کاربر جهانی با ویدیویی که جعلی بودن آن به هیچ وجه قابل تشخیص نبود باعث شد تا نیویورک تایمز از «جعل عمیق» به عنوان «خطرناکترین فناوری قرن» یاد کند.

جعلی یا واقعی؟

بر اساس سنت سالانه انگلستان ساعت سه بعد از ظهر روز کریسمس سخنرانی ملکه الیزابت دوم از طریق تلویزیون ملی این کشور پخش شد و طبق روال معمول شبکه چهار تلویزیون هم به صورت همزمان ویدیوی فرد دیگری را برای مخاطبان خود ارائه کرد. پیشتر در چنین روزی سخنرانی افراد مشهوری از جمله «ادوارد اسنودن»، پیمانکار سابق آژانس امنیت ملی امریکا و ... به صورت همزمان با صحبتهای ملکه پخش شده بود و مخاطبان شبکه چهار امسال ملکه و خانواده سلطنتی انگلستان را مشاهده کردند که در حال رقص و پایکوبی بودند و به نظر میرسید تصاویر ویدیویی را برای شبکه اجتماعی تیکتاک ضبط کردهاند. طولی نکشید که رسانههای خبری توضیح دادند که مردم در حال تماشای نسخه دستکاری شده دیجیتالی ملکه بودند که با استفاده از فناوری جعل عمیق ساخته و صدای او هم توسط «دبرا استیونسون» بازیگر و کمدین مشهور تقلید شده بود.

به گفته شبکه چهار تلویزیون ملی انگلستان، این برنامه به عنوان یک هشدار کاملاً جدی در مورد تهدیدهای بالقوه و خطرناک فناوری جعل عمیق و اخبار جعلی پخش شد و «ایان کاتز»، مدیر برنامههای این شبکه، ویدیوی مذکور را «یادآوری قدرتمندی توصیف کرد که با آن حتی نمیتوانیم به چشمان خود هم اعتماد کنیم.»

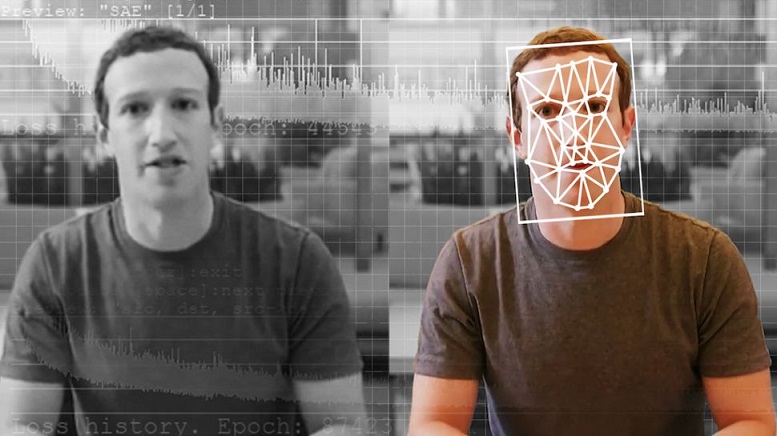

«جعل عمیق» یا «دیپ فِیک» نوع ویژهای از فناوری هوش مصنوعی است که بهواسطه کارکرد خود برای نامگذاری آن دو اصطلاح «یادگیری عمیق» و «جعلی» با هم ترکیب شدهاند. این فناوری تکنیک ویژهای برای ترکیب تصویر انسان مبتنی بر هوش مصنوعی است که در آن تصاویر و فیلمهای موجود روی تصاویر یا فیلمهای منبع قرار میگیرد و از قابلیت ویژه فناوری یادگیری ماشینی موسوم به «شبکه مولد تخاصمی» (GAN) استفاده میشود. ویدیوی جعلی که از این طریق ساخته میشود ترکیب فیلمهای موجود و منبع است که فرد یا افرادی را در حال انجام یک کار در موقعیت ویژه نشان میدهد که هرگز در واقعیت اتفاق نیفتاده است.

این فیلمهای تقلبی میتوانند فرد را در حال انجام اقداماتی نشان دهند که هرگز در آن حضور نداشتند و همچنین از آن برای تغییر کلمات یا حرکات یک سیاستمدار استفاده کنند تا به نظر برسد آن فرد چیزی را گفته که هرگز به زبان نیاورده است. بهعنوان مثال، اکتبر گذشته زمانی که کاخ سفید خبر ابتلای «دونالد ترامپ» به کرونا را منتشر کرد، حساب توئیتری رئیسجمهوری سابق امریکا ویدیوی کوتاهی را از او منتشر کرد که به نظر میرسید دقایقی پیش از سوار شدن ترامپ به هلیکوپتر برای انتقال به بیمارستان ضبط شده بود. ترامپ در این ویدیو از حمایتها و پیامهای محبتآمیزی که در ساعات گذشته دریافت کرده بود تشکر کرد و توضیح داد که حال عمومی او خوب است ولی طولی نکشید که خبرگزاریها با تحلیلهای دقیقتر توضیح دادند این ویدیو به احتمال قوی توسط فناوری جعل عمیق ساخته شده است و در اصل «دونالد ترامپ» واقعی در این ویدیو حضور نداشته است.

پیش از این خبرگزاری چینی شینهوا و موتور جستوجوی اینترنتی Sogou در یک پروژه مشترک با استفاده از فناوری جعل عمیق مجری تلویزیونی را طراحی کردند که شکل ظاهری شبیه یک مرد دارد و با ایجاد صدا و حرکات چهره انسان، اخبار را به صورت کاملاً حرفهای میخواند و بیننده تصور میکند گوینده واقعی در مقابل چشمان او قرار گرفته است. این خبرگزاری چینی کارمند جدید خود را که در اصل وجود خارجی ندارد یک گوینده حرفهای و خستگیناپذیر معرفی کرد که تمامی اخبار روز را به صورت ۲۴ ساعته گزارش میدهد.

مفید یا مضر؟

فناوری جعل عمیق برای برخی کاربران شاید در ابتدا سرگرم کننده به نظر برسد تا با اپلیکیشنهای موبایلی و ساخت این گونه تصاویر ویدیویی بتوانند توجه بیشتری از مخاطبان شبکههای اجتماعی را به خود جلب کنند ولی برای کارشناسان این طور به نظر نمیرسد.

«متئو کالدوِل» از محققان دانشگاه سلطنتی لندن در این خصوص گفت: «مردم این روزها بخشهای زیادی از زندگی روزمره خود را به دنیای مجازی سپردهاند و فعالیت آنلاین آنها روی تمام بخشهای زندگیشان تأثیر میگذارد. محیطهای آنلاین که در آن دادهها از قدرت و اثرگذاری بالایی برخوردار هستند، با استفاده از فناوری هوش مصنوعی برای بهره برداریهای مجرمانه هم به کار گرفته میشوند.»

او همچنین توضیح داد: «جرایم حوزه دیجیتال بر خلاف بسیاری از جرایم سنتی بهراحتی قابل تکرار نیستند و این اتفاق به مجرمان امکان میدهد تکنیکهای جنایی خود را بهصورت انحصاری به بازار عرضه کنند و کاربران را مورد سوءاستفاده قرار دهند. این مسأله به آن معنی است که مجرمان سایبری ممکن است جنبههای چالش برانگیز جنایت مبتنی بر هوش مصنوعی را برون سپاری کنند تا از این طریق بتوانند بهصورت حرفهایتر پروژههای خود را پیش ببرند.»

دانشگاه سلطنتی لندن در بررسیهای خود به این نتیجه رسید که فناوری جعل عمیق این روزها بهصورت ویژه برای ساخت فیلمهای مستهجن مورد استفاده قرار میگیرد. تحقیقات این مرکز در ژوئن ۲۰۲۰ نشان داد ۹۶ درصد تصاویر جعل عمیق در حوزه فیلمهای مستهجن ساخته شده است و تقریباً نزدیک به ۱۰۰ درصد این فیلمها با هدف ضربهزدن به زنان پخش شدهاند. با این حال بسیاری از مردم استفاده از اطلاعات نادرست آنلاین را پیش شرط اصلی برای توسعه تصاویر جعل عمیق میدانند.

در سال ۲۰۱۹ میلادی حزب محافظه کار انگلیس ویدیویی از «کایر استارمر» رهبر فعلی حزب کارگر این کشور منتشر کرد تا نشان دهد او در مصاحبه مطبوعاتی نسبت به گذشته عملکرد بدتری دارد. در این زمینه اقدام مشابه توسط طرفداران حزب جمهوریخواه امریکا صورت گرفت و این اتفاق در نهایت باعث شد نسخه ویرایش شده تصاویر ویدیویی «نانسی پلوسی» رئیس دموکرات مجلس نمایندگان امریکا بین کاربران منتشر شود و حتی «دونالد ترامپ» هم آن را به اشتراک بگذارد.

اگرچه این ویدیوها با فناوری جعل عمیق ساخته نشده بودند و در عوض بهصورت زیرکانه ویرایش شدند ولی این مسأله نشان داد برای محتوای ویدیویی دستکاری شده بازار پرمخاطبی وجود دارد که مخالفان سیاسی میتوانند از آن سوءاستفاده کنند.

محققان علاوه بر محتوای جعل عمیق، پنج فناوری دیگر را هم مورد توجه قرار دادهاند که با استفاده از هوش مصنوعی توسعه پیدا میکنند و در آینده نزدیک میتوانند نگرانیهای زیادی برای مردم ایجاد کنند. استفاده از اتومبیلهای بدون راننده به عنوان سلاح، استفاده از فناوری یادگیری ماشینی برای هدایت پیامهای مخصوص کلاهبرداری، ایجاد اختلال در سیستمهای کنترل ماشینی، نشر اخبار جعلی و جمعآوری اطلاعات آنلاین برای باجگیری پنج فناوری مذکور هستند و باید دید شرکتهای توسعهدهنده سیستمهای امنیت سایبری تا چه اندازه میتوانند با این مشکلات مقابله کنند.»

سایت تابناک از انتشار نظرات حاوی توهین و افترا و نوشته شده با حروف لاتین (فینگیلیش) معذور است.